גוגל מוסיפים עדכון חשוב נוסף לממשק מנהלי האתרים שלהם – גוגל וובמסטר טולס.

לאחר העדכון האחרון שמאפשר לבדוק האם הטמענו נכון את תגיות hreflang למיקוד האתר לשפות שונות, כעת גוגל מוסיפה עדכון נוסף שנועד להקל על מנהלי האתרים – והפעם בגזרת הקובץ רובוטס.

קובץ רובוטס, למי שלא מכיר, הנו קובץ txt (שנעשה בתוכנה כמו notepad למשל) ובו מעדכנים את גוגל אילו דפים אסור לו לסרוק ולאנדקס מתוך האתר שלכם. את הקובץ מעלים לתיקייה ראשית ב- FTP של האתר (בוורדפרס לתיקיית Public HTML) ולמעשה זהו הקובץ הראשוני שגוגל מחפשת כשהיא מגיעה לסרוק אתר. על כן חשוב ליצור קובץ כזה ולוודא את תקינותו.

תוכלו למצוא את הקובץ הנ"ל בצורה פשוטה באמצעות הקלדת כתובת כל אתר ובסיום robots.txt.

למשל באתר שלי: גישה לקובץ ROBOTS באתר

לרוב מיועד הקובץ לחסימה של תיקיות שלמות ולא של דף בודד – אז לרוב מומלץ לבצע חסימה נקודתית באמצעות תגית meta robots “NOINDEX” .

הקובץ מאוד פשוט ומתחיל בדרך כלל בפנייה לאילו מנועי חיפוש הקובץ פונה:

בדרך כלל יפנה הקובץ לכלל מנועי החיפוש וייפתח בשורת הקוד: User-agent: * – כאשר ה- * מתייחס לכלל מנועי החיפוש.

לאחר שורה זו בדרך כלל יופיעו כלל התיקיות שיש לחסום מאינדוקס של גוגל באמצעות שורות הקוד הבאות:

Disallow: /wp-admin – שורת הקוד הנוכחית למשל, חוסמת גישה לתיקיית מערכת ניהול אתר הוורדפרס.

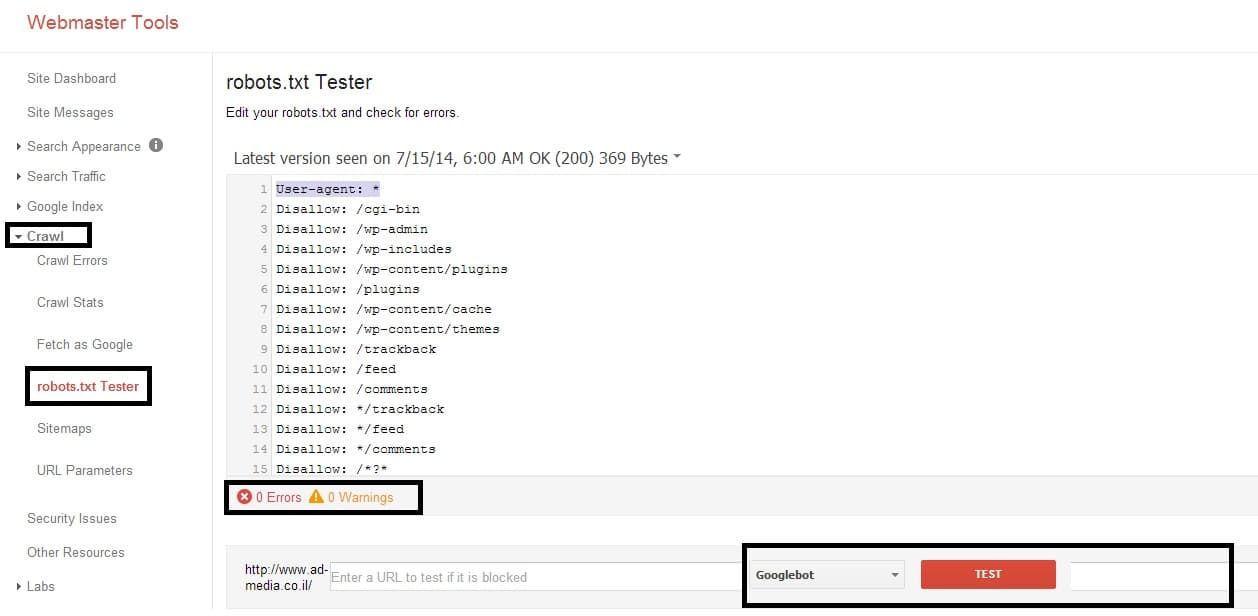

כך זה נראה בתוך הגוגל וובמסטר טולס:

כאמור, כעת גוגל מכניסה עדכון לגוגל וובמסטר טולס שמאפשר לבדוק את יצירת הקובץ ולקבל עדכונים האם קיימות שגיאות בקובץ רובוטס שלכם.

את הכלי החדש תוכלו למצוא בתוך הגוגל וובמסטר טולס – בקישור הזה או לחפש תחת Crawl את ה- robots tester.

בכלי החדש תוכלו להזין כתובות URL מהאתר שלכם ולראות האם הן אכן חסומות ע"י קובץ הרובוטס שלכם. הכלי החדש יעדכן אתכם במידה והוא מזהה טעויות כלשהן שדורשות תיקון. כמו כן ניתן לראות גרסאות קודמות של קובץ הרובוטס שלכם.

אם תרצו לעדכן את קובץ הרובוטס שלכם – עדיין תצטרכו לעדכן אותו פיזית ולהעלות ישירות לשרת או לעדכן אותו דרך הכלים בתוסף יוסט. לא ניתן לעדכן אותו ב- search console.

פוסט נוסף שמומלץ לקרוא בהקשר זה: המדריך להסרת תוכן מגוגל